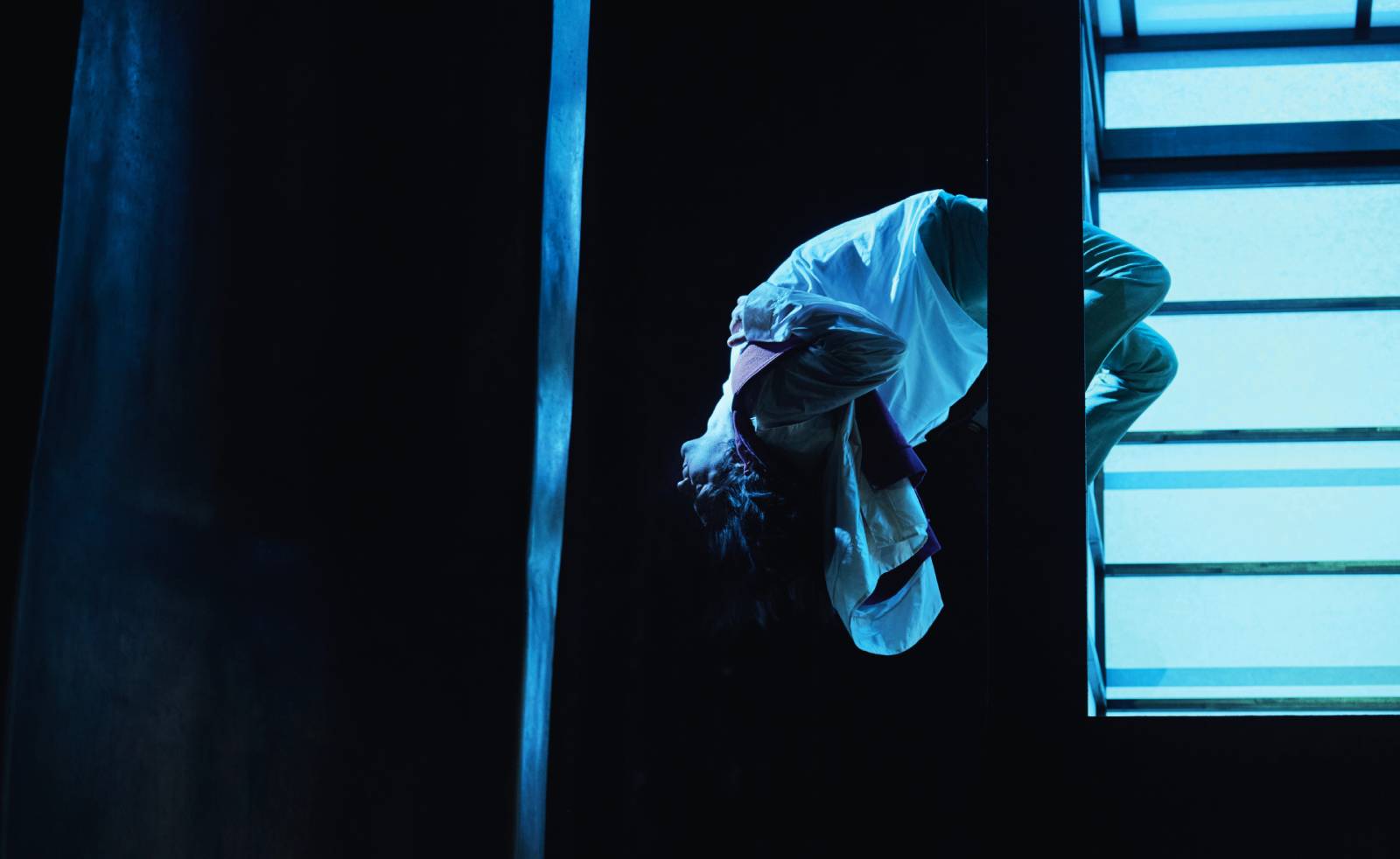

Vom dramatischen Ende einer Radikalisierung: 2016 starben neun Menschen bei einem Amoklauf am Münchner Olympia-Einkaufszentrum, erschossen von einem 18-Jährigen. Anschließend tötete der Täter sich selbst. Der Attentäter hatte sich offenbar unter anderem über entsprechende Kontakte im Netz radikalisiert, auch die Behörden sprachen später davon, dass „rassistische Beweggründe“ bei der Tat eine Rolle gespielt hätten. Drei der Opfer waren Kosovo-Albaner, ihnen galt die hier abgebildete Trauerkundgebung in Pristina, 2016. Foto: Armend Nimani/AFP via Getty Images

Es ist dieses eine Bildpaar, das auf den ersten Blick womöglich sogar harmlos aussieht, an dem sich aber ziemlich gut die Taktik beschreiben lässt, Rassismus und Hass einsickern zu lassen, sagt Diana Rieger. Es ist das Foto eines Schwarzen, der eine Basecap der mit dem Logo der US-Firma Caterpillar trägt – also mit den Buchstaben „CAT“. Daneben das Foto einer finster dreinblickenden Katze, die eine Basecap mit ähnlich gestalteten Buchstaben trägt, allerdings ergeben sie ein ganz anderes Wort: „NIGGER“. Diana Rieger, Professorin für Kommunikationswissenschaft an der LMU, verwendet dieses Meme, wie es in der Netzsprache heißt, als Illustration in einem Aufsatz über rechtsextreme Online-Botschaften. Denn es enthält vieles, was politisch anstößige Inhalte ausmacht, Inhalte, für die die Forschung oft das Adjektiv „inzivil“ verwendet.

Das Meme richtet sich gegen eine Minderheit: Es wird eingesetzt, um einen Schwarzen mit dem Wort „Nigger“ zu belegen, das eine jahrhundertelange Geschichte als zutiefst diskriminierende Sklavenhalter-Sprache in sich trägt. Das Meme verwendet ein Bildmotiv, das schon vorher im Netz weite Verbreitung hatte, vor allem unter Jüngeren: In diesem Fall eine grimmig schauende Katze, die als Grumpy Cat an vielen Stellen zu finden ist. Videos, die extremistische Inhalte verbreiten, nutzen oft Sequenzen aus Filmen oder auch Musik, die fest in der Jugendkultur verwurzelt sind, weiß Rieger. Typisch für extremistische Online-Inhalte sei das CAT-NIGGER-Meme auch, weil es eine Form der Grenzüberschreitung betreibt, die sich darauf berufen könnte, humoristisch zu sein. Auf diese Weise kann das Meme das Ziel des Mainstreaming erreichen, erklärt Rieger: „Es geht darum, bestimmtes Gedankengut sagbar und denkbar zu machen.“ In diesem Fall rassistisches Gedankengut.

Dieses Ziel könnte das Grumpy-Cat-Meme auf besonders subtile Weise erreichen. Es kursiert im Netz in zwei Varianten: Eine mit dem klar rassistischen Wort „NIGGER“. Und eine sozusagen abgemilderte Version mit dem Wort „NEGRO“, das eine andere Tradition hat. Auch die Ikone der amerikanischen Bürgerrechtsbewegung, Martin Luther King, sprachvor rund 60 Jahren in seinen Reden mit großer Selbstverständlichkeit über die „negroes“.

Die Kommunikation von rechts außen hat zugenommen

Rieger untersucht verschiedene Formen, mit denen sich extremistisches Gedankengut im Netz verbreitet. Sie konzentriert sich dabei auf Inhalte, die bestimmte Menschengruppen herabwürdigen, was auf viele rechtsextreme Inhalte zutrifft. Es sei in der Kommunikationswissenschaft stets ein Problem, die Kriterien festzulegen, was unter Oberbegriffe wie „Inzivilität“ oder „Hassrede“ fällt, stellt Rieger fest. Aber inzwischen gebe es viel Erfahrung damit, etwa durch die Befragung von Nutzerinnen und Nutzern, intersubjektiv nachvollziehbare Kriterien zu entwickeln. Auf diese Weise können extremistische Inhalte, egal ob in Textformen, Bildern, Memes oder Videos, über Codierung zählbar und vergleichbar gemacht werden. Und so lassen sich etliche Befunde immer klarer erhärten.

So gebe es eindeutige Belege, dass mit der Ausbreitung des Internet in alle Lebensbereiche auch die Rechtsaußen-Kommunikation zugenommen hat, sagt Rieger. Bereits vor der Coronapandemie gab bei Befragungen vor allem unter Jugendlichen ein Großteil der Befragten an, schon einmal mit extremistischen Inhalten konfrontiert gewesen zu sein. Seit Ausbruch der Coronakrise habe sich diese Entwicklung verstärkt. „Aber Corona ist da nur ein Faktor von vielen“, erklärt sie. Vor allem in einschlägigen Foren der Querdenker-Szene sei dabei der für eine Radikalisierung typische „Prozesscharakter“ zu beobachten: Auch wer anfangs noch keine allzu extremen Positionen einnimmt, wird im Austausch mit Radikalen oft selbst extremer. Bei der Untersuchung von Chat-Verläufen Jugendlicher hat sich diese Radikalisierung wissenschaftlich nachzeichnen lassen.

Rieger warnt dabei vor einem weit verbreiteten Irrtum: „Es gibt ja nicht das Internet. Es geht darum, was auf welcher Plattform geschieht.“ Geschlossene Foren, in denen sich User untereinander in extremistischen Positionen bestärken, bis hin zu Gewaltaufrufen, sind etwas anderes als Hassrede etwa in den Kommentarspalten traditioneller Medienangebote.

Gerade der Schaden, der durch Hass-Kommentare unter journalistischen Angeboten entsteht, ist inzwischen mit kommunikationswissenschaftlichen Methoden gut messbar. Durch Befragungen ist belegt: Auch wenn ein journalistischer Inhalt unter Gesichtspunkten der Professionalität makellos ist, beschädigen Kommentare, die die Qualität dieses Texts oder Filmbeitrags grundlegend in Frage stellen, die Glaubwürdigkeit des jeweiligen Angebots: „Wenn da ein negativer Kommentar steht, dann wird der ganze journalistische Beitrag als weniger glaubwürdig eingeschätzt, weniger vertrauenswürdig“, fasst Rieger den Forschungsstand zusammen. „Aliquid semper haeret“: Die schon seit der Antike in lateinischen Worten bekannte Rhetorik-Weisheit, dass von Beschimpfungen immer etwas hängen bleibt, bestätigt sich im Internet-Zeitalter also jeden Tag aufs Neue.

Das wirksame Prinzip der Gegenrede

Und wie sollte man mit Hassrede und Extremismus auf Online-Plattformen umgehen? Nach Ansicht von Diana Rieger lassen sich aus den Erkenntnissen der Kommunikationswissenschaft verschiedene Ansätze ableiten. Ein denkbarer Weg sei das Tilgen problematischer Inhalte durch die Betreiber einer Plattform, bis hin zum Ausschluss einzelner Personen, also das sogenannte Deplatforming. Durch das Netzwerk-Durchsetzungsgesetz gibt es seit Oktober 2017 in Deutschland eine Pflicht für Plattformbetreiber, strafrechtlich relevante Inhalte zu sperren oder zu löschen. Die Reichweite einer solchen Gesetzgebung sei allerdings beschränkt, sagt Diana Rieger: „Es dauert teilweise ziemlich lange, bis die entsprechenden Inhalte gelöscht werden.“ Und aus dem Management etwa des Internet-Giganten Facebook gebe es die Aussage, geschlossene Gruppen würden ohnehin nicht kontrolliert: „Also Gruppen, in denen die Mitglieder dann vielleicht noch härtere Posts teilen – da ist die Reglementierung dann auch relativ schnell am Ende“.

Wenn vor allem Plattformbetreiber die Verantwortung dafür übernehmen sollen, dass keine Hassbotschaften über ihre Angebote verbreitet werden, ergebe sich auch ein Problem, mit dem man erst einmal nicht unbedingt rechnen würde, sagt Rieger. Sie zeichnet mitverantwortlich für eine bevölkerungsrepräsentative Umfrage unter anderem zur Frage, unter welchen Bedingungen jemand bereit ist, falschen oder hassgeprägten Aussagen zu widersprechen. Dabei ist deutlich geworden: „Diejenigen, die sagen, dass eigentlich die Plattformbetreiber verantwortlich sind, zeigen weniger Motivation, auch selber Verantwortung zu übernehmen in Form von Gegenrede.“

Widerspruch gegen herabwürdigende Online-Inhalte und Falschbehauptungen, also Gegenrede, ist ein Thema, bei dem die Kommunikationswissenschaft zu unterschiedlichen Forschungsergebnissen kommt. Es gibt Untersuchungen, die nahelegen, dass aufklärerisch angelegte und vor allem an Jugendliche gerichtete Kampagnen, etwa der Bundeszentrale für politische Bildung, Hassrede-Kommentare erst auslösen. Ein anderes beobachtetes Phänomen ist aus der Psychologie als „bystander effect“ etwa bei Unfällen bekannt: Wenn es viele potenzielle Zuschauerinnen und Zuschauer gibt, sind einzelne weniger bereit, selbst einzugreifen. Ein solcher Effekt sei mitunter auch in Onlineforen zu beobachten, weiß Rieger. Wenn einzelne Widerspruchsmeldungen gegen Hassbotschaften zu sehen sind, halten sich andere, die vielleicht grundsätzlich auch widersprechen würden, eher zurück. In der Summe aber zeigten die Ergebnisse der Kommunikationswissenschaft, dass Gegenrede ein probates Mittel gegen Hassrede und Falschbehauptungen sei, betont Rieger. Dabei müsse gar nicht das Ziel sein, diejenigen zu überzeugen, die Falschbehauptungen oder Fake News veröffentlichen. Es gehe vielmehr darum, ein bestimmtes Diskussionsklima aufrecht zu erhalten: „Dann wird wahrgenommen, hier kann ich nicht vom Leder ziehen, ohne dass ich sanktioniert werde.“ Es gebe aus Befragungen auch vergleichsweise starke empirische Belege dafür, „dass Gegenrede die Zivilität stärkt und die Inzivilität schwächt“. Und eine wichtige Funktion von Gegenrede bestehe auch darin, die Gruppen zu stärken, die durch Hassrede angegriffen werden: „Es geht auch darum zu zeigen: Hier ist kein Raum, in dem ich allein gelassen werde, sondern hier wird sich gewehrt.“

Mehr Medienkompetenz für Multiplikatoren

Forderungen nach „mehr Medienkompetenz“ lösen bei Rieger gemischte Gefühle und Gedanken aus. Der Begriff sei oft in der Gefahr, zur Worthülse zu verkommen, warnt sie. Aber selbstverständlich sei es dringend nötig, vor allem bei Multiplikatorinnen und Multiplikatoren etwa in der Schule die Kompetenz für den Umgang mit extremistischen Online-Inhalten zu schärfen. Allerdings müsse erst einmal herausgefunden werden, welche Kompetenzen denn tatsächlich fehlen, wo die Defizite liegen, die es auszugleichen gilt. Hier ist sie maßgeblich an einem Projekt beteiligt, um bei Lehrkräften zu erheben, welche Art von Medienkompetenz die Lehrerinnen und Lehrer erst noch erwerben müssen, um diese dann wiederum an Schülerinnen und Schüler weitergeben zu können. Dass dabei viele Gratwanderungen zu bewältigen sind, liegt für Diana Rieger auf der Hand: „Wenn ich zeige, worum es geht, dann zeige ich Minderjährigen extremistische Propaganda im Schulunterricht.“ Etwa ein Meme zu zeigen, auf dem ein Schwarzer ein Käppi mit der Aufschrift „CAT“ trägt, und eine Katze ein Käppi mit der Aufschrift „NIGGER“, will wohlüberlegt sein. Und es gelte auch weiterhin der Beutelsbacher Konsens zu den Grundsätzen politischer Bildung, der schon in den 1970er Jahren bei einer Tagung in der baden-württembergischen Kleinstadt Beutelsbach formuliert wurde. Danach soll in der Schule oder der politischen Bildung keine Indoktrination erfolgen. Es sei auch nicht erlaubt, die Heranwachsenden „im Sinne erwünschter Meinungen zu überrumpeln“, heißt es im Beutelsbacher Konsens.

Neben der Frage, wie sich schädliche Wirkungen von Hassrede begrenzen lassen, wünscht sich Rieger auf zwei weiteren Feldern zusätzliche Antworten, zu denen die Kommunikationswissenschaft ihrer Ansicht nach viel beitragen kann. Es gebe noch zu wenige Längsschnitt-Untersuchungen, wie sich Hassrede über einen längeren Zeitraum entwickelt. Die meisten Studien seien eher punktuell ausgerichtet. Und Zusammenhänge zwischen dem, was im Netz und in der realen Welt passiert, seien ebenfalls noch zu wenig ausgeleuchtet.

Eine Frage, die sie gerne untersuchen würde, formuliert Rieger so: „Sind die, die sich viele Monate lang bei Telegram oder bei „Querdenken“ hassvoll über die Regierung ausgetauscht haben, letztendlich auch diejenigen, die durch Stuttgart und andere Städte laufen und Scheiben einschlagen? Gibt es einen Zusammenhang, dass Hass online zu Hass offline führt?“ Es ist dies eine Frage, an der sich Wissenschaftlerinnen und Wissenschaftler schon zuhauf abgearbeitet haben. Die Frage, so ergänzt sie, könnte aber auch anders herum gestellt werden: „Bin ich von irgendeinem Ereignis in der realen Welt so beeindruckt, dass ich mich danach Online-Hassgruppen zuwende?“ Es sei „die Königsdisziplin der Sozialwissenschaft, realweltliches Verhalten messbar machen zu können“, sagt Rieger und lässt keinen Zweifel daran, dass es ein wichtiger Teil ihres Arbeitsprogramms ist, die Anknüpfungspunkte zu nutzen, die die Analyse der Kommunikation im Netz bietet.

Nikolaus Nützel

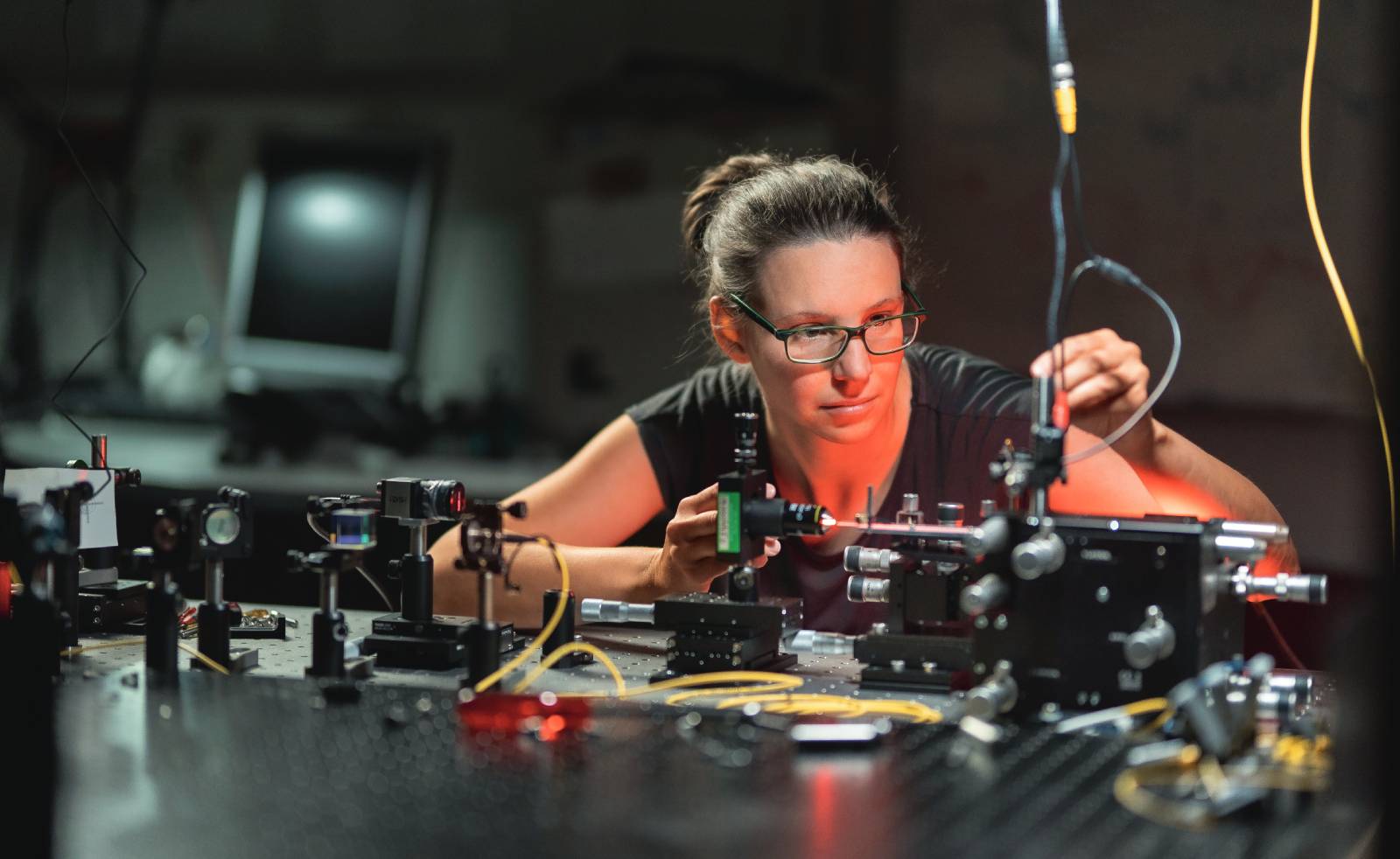

Prof. Dr. Diana Rieger

ist Professorin für Kommunikationswissenschaft am Institut für Kommunikationswissenschaft und Medienforschung (IfKW) der LMU. Rieger, Jahrgang 1984, studierte Medienwissenschaft an der Universität zu Köln, wo sie auch promoviert wurde. Sie lehrte und forschte unter anderem an der American University of Sharjah, Vereinigte Arabische Emirate, der Michigan State University, USA, und zuletzt der Universität Mannheim, bevor sie 2018 an das IfKW berufen wurde.

0 Kommentare