Im Oktober 2018 wurde beim Auktionshaus Christie’s ein Porträt versteigert, das einen „Edmond de Belamy“ darstellen soll. Das Bildnis zeigt das Gesicht eines unbekannten jungen Mannes – Christie‘s beschreibt ihn als „Gentleman, vielleicht ein adliger Kleriker“ –, der um die Mitte des 19. oder zu Beginn des 20. Jahrhunderts gelebt haben könnte. Diese Zuschreibungen zur Person mit den im Bild unscharf dargestellten Zügen unter einer hohen Stirn sind allerdings nur Vermutungen, die sich der kunsthistorischen Einordnung des Mal-Stils verdanken. Denn das Gemälde strebt keine naturalistisch exakte Abbildung eines Menschen an, es atmet vielmehr den Aufbruchsgeist der frühen Kunst-Avantgarden der Moderne, ist eher ästhetische Impression als Abbild. Ein Ausdruck künstlerischer Freiheit also, der 2018 am Auktionstag 432.500 Dollar erlöste.

Allein, mit der Freiheit des Künstlers ist es hier nicht weit her. Denn es gibt keinen Künstler.

Nahezu verschämt in der rechten unteren Ecke des Bildes, dort, wo Meister sonst ihr Werk unterzeichnen, ist folgende Bild-Signatur angebracht: „min G max D x[log (D(x))] + z [log (1 –D (G(z)))]“.Das ist ein Fragment des Computercodes, der das Bild errechnete, der Urheber des Bildes ist ein Computer, besser gesagt: eine Künstliche Intelligenz (KI).

Und ist es auch wieder nicht. Denn irgendjemand muss die vernetzten Computer, die hinter der KI stehen, ja so programmiert haben, dass sie diesen „schönen Freund” (bel amy) malen konnte. Doch auch das tat hier niemand. Der Algorithmus, dem sich das Porträt verdankt, entstand in einem Tandem aus zwei selbstlernenden Neuronalen Netzen, die souverän gegeneinander antreten. Man spricht von einem GAN, einem „Generative Adversarial Network“. Eine „Generator“ genannte Hälfte dieses Verbundes wurde mit den Daten von 15.000 real gefertigten Kunstportraits aus der Kunstgeschichte gefüttert, die zwischen dem 14. und 20. Jahrhundert entstanden sind.

Ein ganzer Stammbaum, eine fiktive Dynastie der Belamys

Der Generator fertigte – basierend auf diesem Set – völlig neue Bilder, die einer Kontrollinstanz, dem „Discriminator“, zur Prüfung vorgelegt und als mutmaßlich menschengemacht untergejubelt wurden. Nicht nur ein Bild ist auf diese Weise produziert worden, tausende waren es. So entstand ein ganzer Stammbaum, eine fiktive Dynastie der Belamys; mit einem Grafen und einer Gräfin Belamy, einer Baronin und einem Erzbischof – eine synthetische Genealogie, die sich dem Überbietungsspiel Künstlicher Intelligenzen verdankt. Seitdem bebt die Kunstwelt.

Denn wenn es intelligenten Computernetzwerken durch Deep Learning gelingt, lediglich inspiriert von der Kunstgeschichte, eigenständige neue Werke zu schaffen, unterscheidet sie das noch von menschlichen Künstlern? Muss man sie also kreativ nennen? Die Gruppe „Obvious Collective“, die das „Portrait of Edmond de Belamy” zur Versteigerung einreichte (und die halbe Million kassierte – sind sie die Künstler? –), beweist darum einen milden Sinn für Sarkasmus, wenn sie ihrem „Belamy“-Clan in der Titelei mitgibt: „The shadows of the demons of complexity awaken by my family are haunting me.“ (Die Schatten der Dämonen der Komplexität, die meine Familie entfesselt hat, verfolgen mich.)

Inzwischen sind fast fünf Jahre vergangen, synthetische Bilderzeuger können nun von jedermann mit einfachen Textbefehlen zur Bildproduktion angeregt werden: DALL-E 2 oder Midjourney sind nur zwei Namen, die gerade kursieren. Die KI entwickelte sich nicht nur in der Bildenden Kunst rasant weiter. Inzwischen lassen Schüler und Studenten ihre Hausarbeiten von einer „ChatGPT“ schreiben.

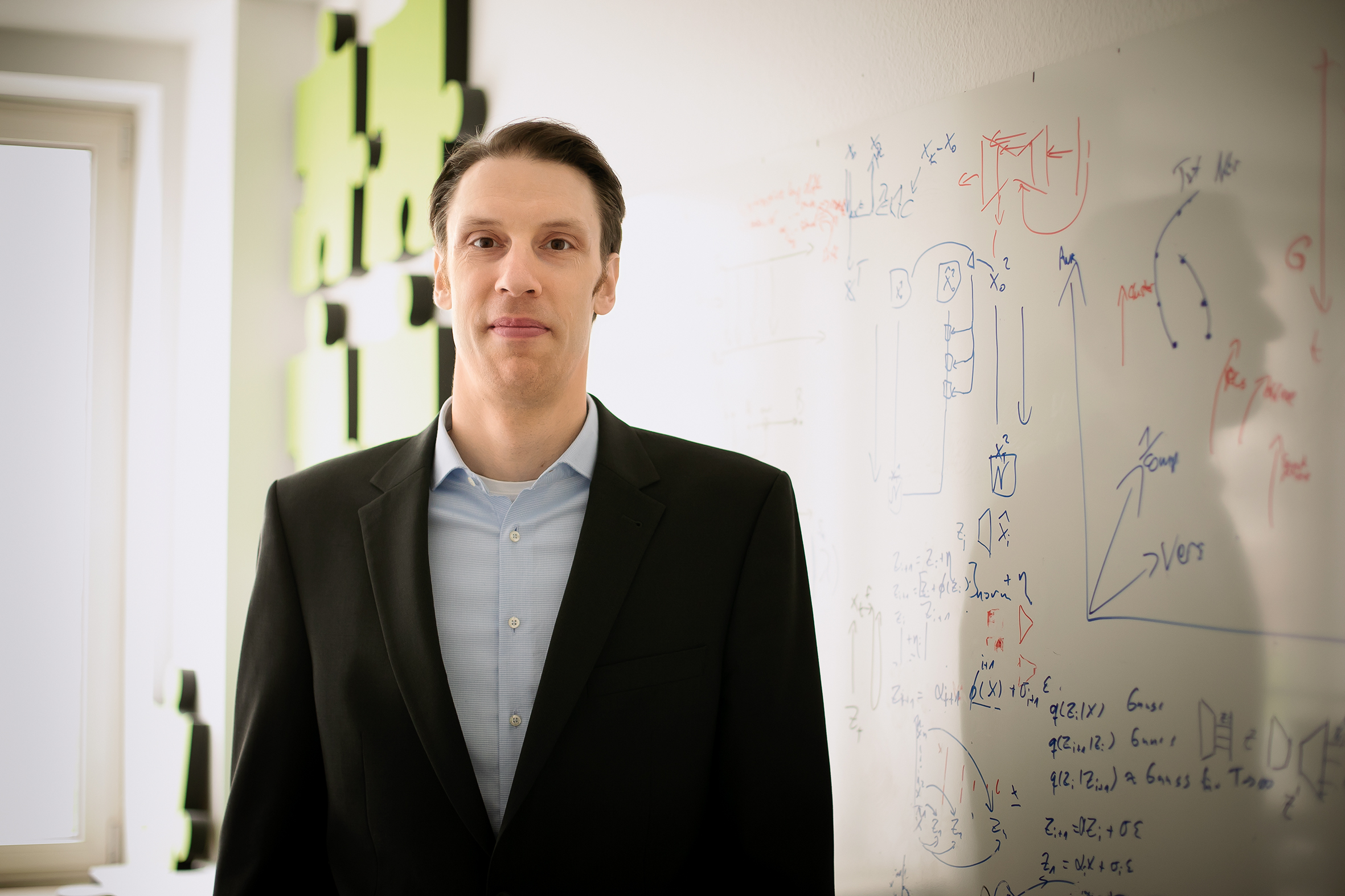

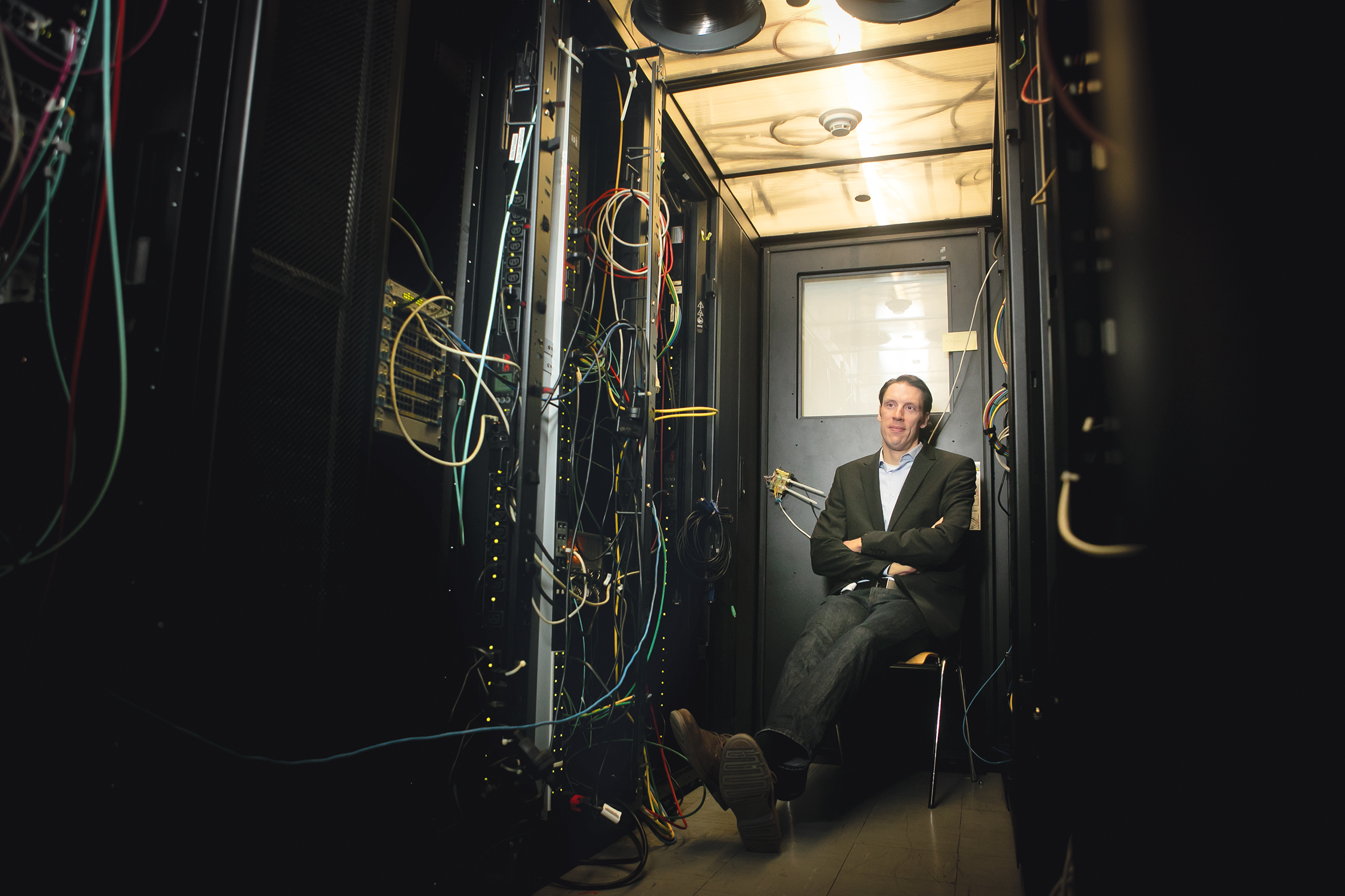

Doch niemand ist besser geeignet, die mutmaßlich entfesselten Dämonen der KI wieder einzufangen, die bewältigten und die bestehenden Probleme in der Forschung zu benennen als Professor Björn Ommer. Er hat an der LMU München den Lehrstuhl für KI für Computer Vision und Digital Humanities / die Künste inne und leitet die Computer Vision & Learning Group (CompVis), die eine eigene Bilderzeugungs-KI, genannt Stable Diffusion, entwickelt hat. Er erforscht computerbasiertes Verstehen und Erzeugen von Bildern durch Künstliche Intelligenzen im Verfahren des Machine Learnings befasst.

Die KI findet Strukturen im Nebel

Ommers Arbeit im Bereich der Computer Vision ermöglicht es Rechnern, visuelle Informationen zu interpretieren und aus diesen völlig neuen Bildern aus ihrem „Verständnis” heraus zu generieren. Björn Ommer bringt Computern also gewissermaßen das Sehen und Malen bei, und zwar so, dass natürlichsprachliche Text-Eingaben in neue Bilder umgesetzt werden. In dem dabei verfolgten Ansatz, einem „umgekehrten Diffusionsprozess“, lernen Netzwerke zuerst, Bilder zu verrauschen, um sie anschließend dazu zu bringen, aus verrauschten Bildern weniger verrauschte Versionen zu erstellen, also Strukturen im Nebel zu finden, die schließlich wieder zu immer plausibleren, detailreicheren Bildern führen.

Es sind keine Abbilder, die so entstehen, es sind überzeugend wirkende Bilderfindungen. „Stable Diffusion“, sagt Ommer, „ist ein generatives KI-System, mit dem man dem Computer per Texteingabe ganz einfach beschreiben kann, was man gerne in einem Bild hätte. Und der Computer setzt den Text dann in ein Bild um.“ Sein Team hat also ein System entwickelt, das Bilder und in Zukunft auch Videos und 3D-Modelle generiert, indem der Nutzer einfach nur beschreibt, was in einem Bild oder Video zu sehen sein soll. „Ich habe jetzt die Möglichkeit, dem Computer zu sagen: ‚Schaffe und editiere bitte ein Bild, und zwar so, wie ich es gerne hätte’”, sagt Ommer. Es scheint eine gewisse Ironie der Geschichte darin zu liegen, dass Ommers Büro sich in der Münchner Akademiestraße befindet, und zwar exakt auf der gegenüberliegenden Straßenseite der Akademie der Bildenden Künste. Hier wie dort werden neue Kunstwerke generiert, wenn auch hier bei Ommer nach einem Wahrscheinlichkeitsmodell errechnet und nicht wie dort genialisch entworfen. Oder etwa doch?

Ommer ist sich der Tragweite seiner Entwicklung bewusst. Denn er hat nicht nur aus dem tumben Rechenknecht Computer ein kreatives Werkzeug gemacht, er greift für die Bildproduktion auch in den Prozess unserer menschlichen Wahrnehmung der Welt und damit in das Verstehen von Wirklichkeit ein. „Dieser Ansatz belegt dann die Fähigkeiten des Systems, die es mit dem Menschen teilt. Klar, es geschieht auf einem etwas anderen Weg als bei uns Menschen. Doch ist auch klar, wenn menschliche Fähigkeiten im Computer repliziert werden, dass man dadurch natürlich auch besser versteht, wie diese Intelligenz bei uns gestaltet ist.”

Ein Algorithmus, gemacht für den Rechner zuhause

Es gibt Unterschiede in der Entwicklung bildgenerativer Verfahren durch Künstliche Intelligenzen. Während die GANs a´la belamy konträr arbeitende neurale Netzwerke gegeneinander antreten lassen, verrauschen Diffusion-Modelle wie das von Björn Ommers Lehrstuhl zuerst riesige Sets an Trainingsdaten. Diesen Bilddaten werden kontrolliert Fehlinformationen mitgegeben (Rauschen), bis das Bild anschließend völlig unkenntlich geworden ist. „Für uns Menschen sind diese Minimal-Störungen zuerst fast gar nicht beobachtbar. Wenn ich ein Bild aber Hunderte oder 1.000-mal hintereinander diesem Prozess unterziehe, dann kommt am Ende etwas heraus, was wirkt, als ob Sie das Kabel aus Ihrem Fernseher herausziehen.“

Seine Neuralen Netzwerke werden nach Wahrscheinlichkeitsmodellen anschließend darauf trainiert, diesen Prozess wieder rückgängig zu machen, also die Bildzerstörung durch allmähliches Entfernen des Rauschens zu revidieren. Ein Text-Encoder wird schließlich auf die Bank verrauschter Daten angesetzt, aus dem der Decoder des Diffusions-Modells in einer Verkettung von Entrauschungsschritten die neuen, synthetischen Bilder erzeugt.

„Ich möchte eine Maschine haben, die tut, was ich sage, die aber nicht selbstbestimmt ist. So verorte ich die Kreativität und das Künstlersein des Menschen.“

Was Ommers Entwicklung der Stable Diffusion (neben allen technischen Differenzen) von den namhaften Konkurrenten unterscheidet: Sein Team hat einen Algorithmus entwickelt, der eine Repräsentation für Bilder lernt, die so kompakt ist, dass sie in der Ausführung keine Rechencluster mehr benötigt. Sie läuft auf gewöhnlicher Consumer Hardware und generiert in wenigen Sekunden Bilder. Dazu musste die Essenz der Trainingsdaten so abstrahiert werden, dass Milliarden Trainingsbilder in wenige Gigabyte auf dem eigenen PC passen. Denn erst eine KI, die so kompakt ist, dass sie auf herkömmlicher Hardware von Millionen von Nutzern läuft, ermögliche eine Demokratisierung dieser Technologie, sagt Ommer.

Entsprechend hat sich das Münchner Team bewusst dafür entschieden, ihre KI als Open Source öffentlich zu machen (https://stablediffusionweb.com/#demo). Es gibt den Sourcecode (https://github.com/CompVis/stable-diffusion) und sogar fertige Apps für handelsübliche Computer, die dieses KI-System anders als alle anderen völlig unabhängig von Firmenregularien und -interessen lauffähig machen.

Google und Meta (Mutterkonzern von Facebook, Instagram und WhatsApp) haben ihre neuen Bild- und Videogeneratoren nicht öffentlich zugänglich gemacht. Der Bildgenerator Dall-E 2 ist zwar öffentlich verfügbar, aber die Kontrolle liegt bei der kalifornischen Firma Open AI, die auch den Sprachbot ChatGPT entwickelt hat und unter anderem von Microsoft finanziert wird. Es gibt nicht einsehbare Einschränkungen und Sicherheitsfilter – Modell und Trainingsdaten bleiben ebenso geheim wie der Code, der das alles in Gang setzt.

Damit die Systeme nicht abgeschottet laufen

Auch wenn wirtschaftliche Aspekte sicher eine Rolle spielen, wird dies zuerst einmal mit den Risiken begründet: Die Bildgeneratoren können ja auch für Pornografie und Fake News genutzt werden. „Wenn man das weiterspinnt,“ so Ommer, „bedeutet das, dass in Zukunft nur noch sehr wenige Tech-Firmen diese Forschung vorantreiben könnten.“ Denn die Systeme der großen Tech-Korporationen sind so angelegt, dass sie auch während der Ausführung, nicht nur während des Trainings, große Rechnerfarmen benötigen. „Da fragt man sich schon“, so Ommer, „wo Forschung und Anwendung in Zukunft hingehen, wenn nur weniger als eine Handvoll Firmen über die Ressourcen und dann auch das Wissen und die Algorithmen verfügt, solche Systeme anwendbar zu betreiben und lauffähig zu halten.“ Zum anderen aber zeige die Entwicklung von Open-Source-Software, „dass die Qualität aller Entwicklungen enorm davon profitiert, dass möglichst viele schlaue Köpfe an etwas forschen können und eigene Lösungen entwickeln, die auf offenem Code aufbauen.“

Für Ommers Arbeit ist darum diese Fragestellung elementar: „Wie können wir dagegen ein leistungsfähiges Werkzeug bauen, das gleichzeitig frei zugänglich ist und auf erschwinglicher Hardware für jedermann läuft?“ Das ist ihm mit Stable Diffusion gelungen. Doch wie hat er Milliarden von Trainingsdaten, hunderte Terabyte – man möchte sagen: das Internet – so verdichtet, dass handelsübliche Rechner seinen Bildgenerator verwenden können?

Unwichtig, wie jeder einzelne Grashalm ausgerichtet ist

„Bilder bestehen aus Millionen von Pixeln. Aber auf die einzelnen Pixel kommt es vermutlich nicht so sehr an. Wenn wir Bilder betrachten, erwarten wir, dass der Schattenwurf oder eine Spiegelung stimmen. Aber wie etwa jedes einzelne Haar auf einem Kopf, jeder Grashalm auf einer Wiese ausgerichtet ist, ist nicht wichtig. Sondern vielmehr, dass an der richtigen Stelle Haare sind, die stimmig sind in Farbe und Länge. Das war der Ansatz: Wir komprimieren Bilder, um deren Essenz zu behalten.“ Das setze das System ab von den anderen. Es extrahiere diese Essenz, um dann in einer deutlich komprimierten Repräsentation den Diffusionsprozess laufen zu lassen. „Die lokalen Details, die kaum jemand beachtet, werden dann einfach hinzuhalluziniert, gewissermaßen stochastisch erfunden.“ Auch einen Künstler interessiere ja eher die Darstellung einer Wiese als der Wuchs jedes einzelnen Grashalms darauf, sagt Ommer. „Das ermöglicht uns, hunderte Terabyte einzudampfen.“

„Beuys hat einmal gesagt, der Mensch ist der wahre Künstler, weil der Mensch das einzige selbstbestimmte Wesen ist und damit der Souverän schlechthin.“

Trotzdem bleiben gewichtige Fragen fast beängstigend ungeklärt. Ist die künstliche Kreativität die endgültige Kränkung des human-narzisstischen Dünkels, einzigartig zu sein? Muss der Mensch also zum vierten Mal in seiner Kulturgeschichte – nach Kopernikus, nach Darwin und nach Freud – nun auch noch hinnehmen, dass seine vermeintlich exklusive Fähigkeit, Kunstwerke zu schaffen, nur eine Chimäre war? Verkraften musste er ja bereits, dass er nicht das Zentrum der Welt, sondern nur ein kosmisches Partikel ist, nicht die Krone der Schöpfung, sondern nur Produkt der Evolution, und seine Seele „nicht allein im eigenen Haus“ (Freud) wohnt, sondern von unbewussten Trieben bestimmt wird. Steht also jetzt auch noch seine Schaffenskraft im Schatten schnöder Rechenpower?

Weitere, weniger metaphysische Fragen schließen sich an: Müssen Künstler, Grafiker, Illustratoren, Fotografen nun um ihre Jobs bangen? Wer ist eigentlich Urheber errechneter Werke: die Betreiber der Netzwerke? Deren Programmierer? Die Besitzer der Bilddatenbanken, mit denen die Netzwerke trainiert werden? Was ist noch ein „Original“, wenn bildgebende Verfahren Bilder, Illustrationen, fotorealistische Szenen nach Eingabe von ein paar Stichwörtern fertigen und „Belamys“ jederzeit von jedem auf Knopfdruck hergestellt werden können? Wie aber wird dann die Bildwelt der Zukunft aussehen, wenn nun die endgültige Fusion von allem mit allem ansteht, das „Anything Goes“, das der Postmoderne bislang nur hypothetisch dämmerte? Und: Sind die Resultate tatsächlich eine belamy-stische halbe Million Dollar pro Bild wert?

Gibt es ein Urheberrecht an den errechneten Werken?

Nur so viel ist klar: Rechner und Netzwerke sind keine juristischen Personen, die darum auch nicht Schöpfer eines Originalwerks sein können und denen demnach exklusive Rechte an „ihrem“ Werk gewährt werden. Wenn also ein KI-System ein Kunstwerk ohne menschliches Eingreifen generiert, stellt sich die Frage, ob dann der KI-Entwickler ein Urheberrecht an den errechneten Werken besitzt.

Aber muss dann nicht auch berücksichtigt werden, dass die Milliarden an menschengemachten Originalbildern, die von Neuronalen Netzen als Trainingsdaten genutzt wurden, weiterhin Rechte an diesen ihren Werken geltend machen können? Derzeit ist das Recht in dieser Angelegenheit unklar, verschiedene Rechtsprechungen in verschiedenen Ländern können unterschiedliche Ansätze haben.

Gerade weil aber keine dieser rechtlichen Fragen derzeit befriedigend beantwortet werden kann, kocht Ommer sie aufs Pragmatische herunter, auf das also, was sich nun sagen lässt. „Ich möchte den Computer nicht in den automatischen Künstler verwandeln, Künstler arbeitslos machen oder ähnliches. Das Ziel ist es nur, Computer zu einem leistungsfähigeren Werkzeug dafür zu machen, die menschliche Kreativität umzusetzen.“

Doch hat der Mensch seine Kreativität dann nicht einfach nur an die Maschine delegiert, lässt ihn machen, wozu er selber nicht fähig ist? Ommer antwortet darauf: „Beuys hat einmal gesagt, der Mensch ist der wahre Künstler, weil der Mensch das einzige selbstbestimmte Wesen ist und damit der Souverän schlechthin. Das sagt mir stark zu. Ich möchte eine Maschine haben, die tut, was ich sage, die aber nicht selbstbestimmt ist. So verorte ich die Kreativität und das Künstlersein des Menschen. Da bleibt genügend Raum, in dem wir Menschen uns immer noch als das Besondere gegenüber der Maschine begreifen können. Wir werden nicht von Künstlicher Intelligenz vom Thron gestoßen.“

Bernd Graff

Prof. Dr. Bernd Ommer

ist Inhaber des Lehrstuhls für KI für Computer Vision und Digital Humanities / die Künste an der LMU und leitet die Computer Vision & Learning Group (CompVis). Ommer, Jahrgang 1981, studierte Informatik mit Nebenfach Physik an der Universität Bonn. Promoviert wurde er im Fach Informatik an der ETH Zürich, danach ging er als Postdoktorand an die University of California in Berkeley. Von 2009 an war Ommer Professor an der Universität Heidelberg und dort auch Co-Direktor des Interdisziplinären Zentrums für Wissenschaftliches Rechnen, bevor er im Jahr 2021 an die LMU kam.

0 Kommentare