Es gibt wissenschaftliche Begriffe, die es in die Alltagswelt geschafft haben. LMU-Wissenschaftler erklären an dieser Stelle solche Ausdrücke – nicht nur mit einer reinen Definition, sondern auch mit einer kurzen Geschichte ihrer Popularität.

„Maschinen sollen menschliche Sprache verstehen und selbst generieren können. Aus dieser Idee entstand ein interdisziplinäres Forschungsgebiet, das sich mit Computersoftware zur maschinellen Verarbeitung menschlicher Sprache beschäftigt: das Natural Language Processing (NLP), auch Computerlinguistik oder Language Technology genannt.

NLP ist also ein Kernbereich der Künstlichen Intelligenz (KI), der sich mit menschlicher Sprache befasst, daneben boomen gerade auch Bildgeneratoren, also Systeme, die sich mit dem Verstehen und Erzeugen von Bildern beschäftigen. Der Schwerpunkt bei NLP liegt heute auf modernen datengesteuerten Ansätzen und Methoden, die maschinelles Lernen auf großen Textmengen anwenden. Sie erkennen Muster in Sequenzen aus sprachlichen Einheiten, wie zum Beispiel Buchstaben, Wörter, Phrasen, Sätze, sowie gesprochene Sprache oder eine Verbindung von Bildern und Texten. Der Begriff NLP hat sich in den letzten Jahren durch die Popularität von NLP-Systemen wie Alexa, Siri und Large Language Models wie BERT und ChatGPT weit verbreitet, obwohl der Begriff und das Feld seine Ursprünge bereits in den 1930er- und 1940er-Jahren hat mit dem Beginn der Studie an maschineller Übersetzung.

NLP ermöglicht es Computern, über KI-Methoden mit Menschen zu kommunizieren. Sie sind damit in der Lage, Texte zu verstehen, Fragen zu beantworten oder Texte aus anderen Sprachen zu übersetzen. Inzwischen übernimmt NLP auch komplexere Aufgaben: Es lassen sich damit Informationen aus unstrukturierten Texten herausziehen oder Artikel maschinell übersetzen. Die neueste, viel diskutierte Entwicklung ChatGPT kann sogar eigene, redegewandte Texte generieren.

Frühe Ansätze gründeten auf regelbasierten Systemen, bei denen Grammatikregeln und Lexika verwendet wurden, um Texte zu analysieren oder generieren. Doch diese Ansätze hatten ihre Grenzen, da menschliche Sprache vielfältig und oft implizit und uneindeutig ist. Mit dem Aufkommen von statistischen Methoden, Maschinellem Lernen und vor allem Methoden, die auf neuronalen Netzen (Deep Learning) basieren, hat sich das Feld rasant weiterentwickelt.

Die Vielfalt der menschlichen Sprache, einschließlich Ironie, Mehrdeutigkeiten und Minderheitensprachen oder Dialekten, stellt nach wie vor eine große Herausforderung dar. Zudem müssen ethische Aspekte wie Datenschutz und Fairness bei der Entwicklung von NLP-Systemen berücksichtigt werden. Insgesamt aber hat NLP das Potenzial, die Art und Weise, wie wir mit Computern interagieren, grundlegend zu verändern. Es ermöglicht eine natürlichere und effektivere Kommunikation zwischen Mensch und Maschine.“

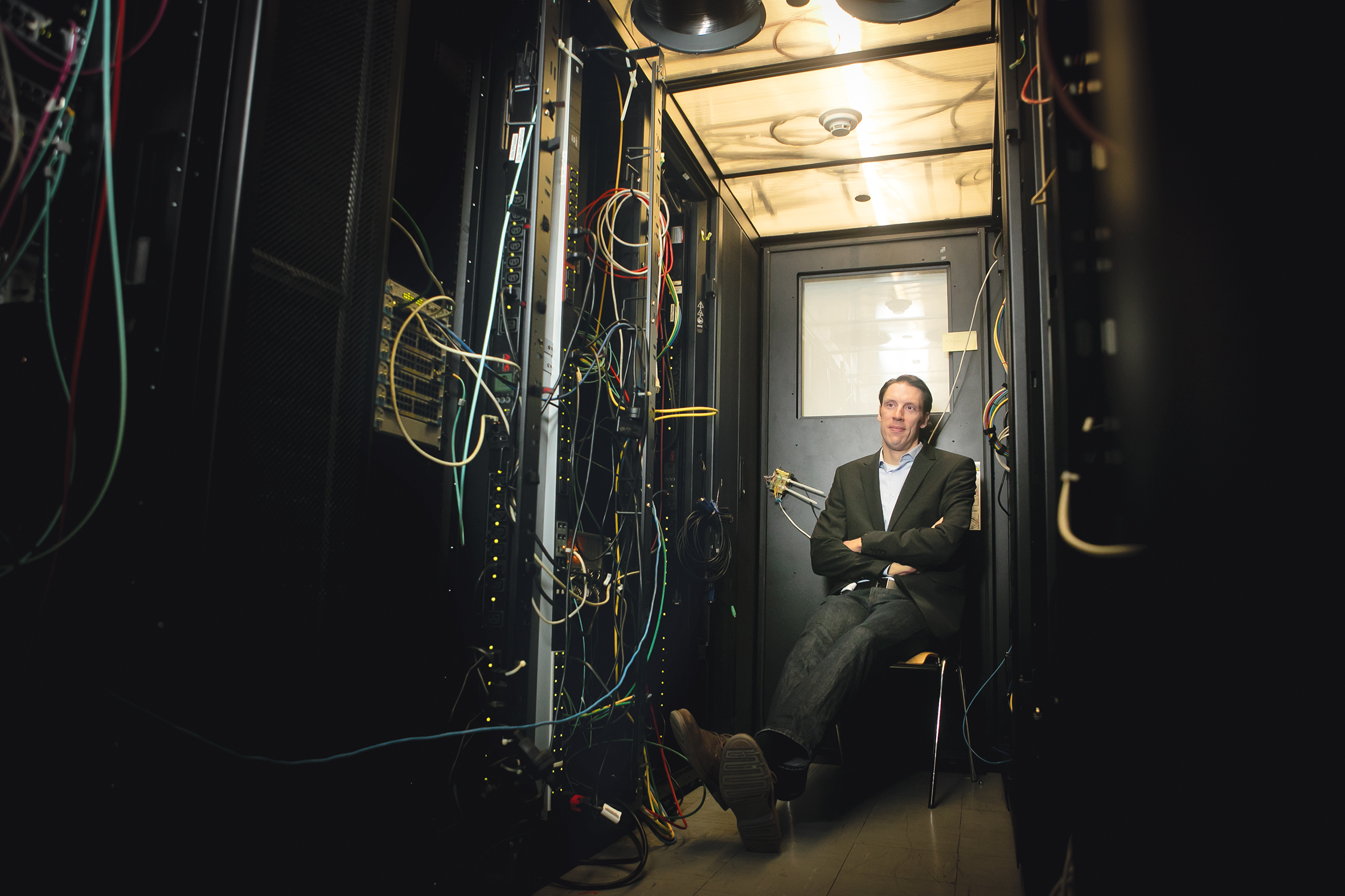

Prof. Dr. Barbara Plank ist Professorin für Künstliche Intelligenz und Computerlinguistik an der LMU

0 Kommentare