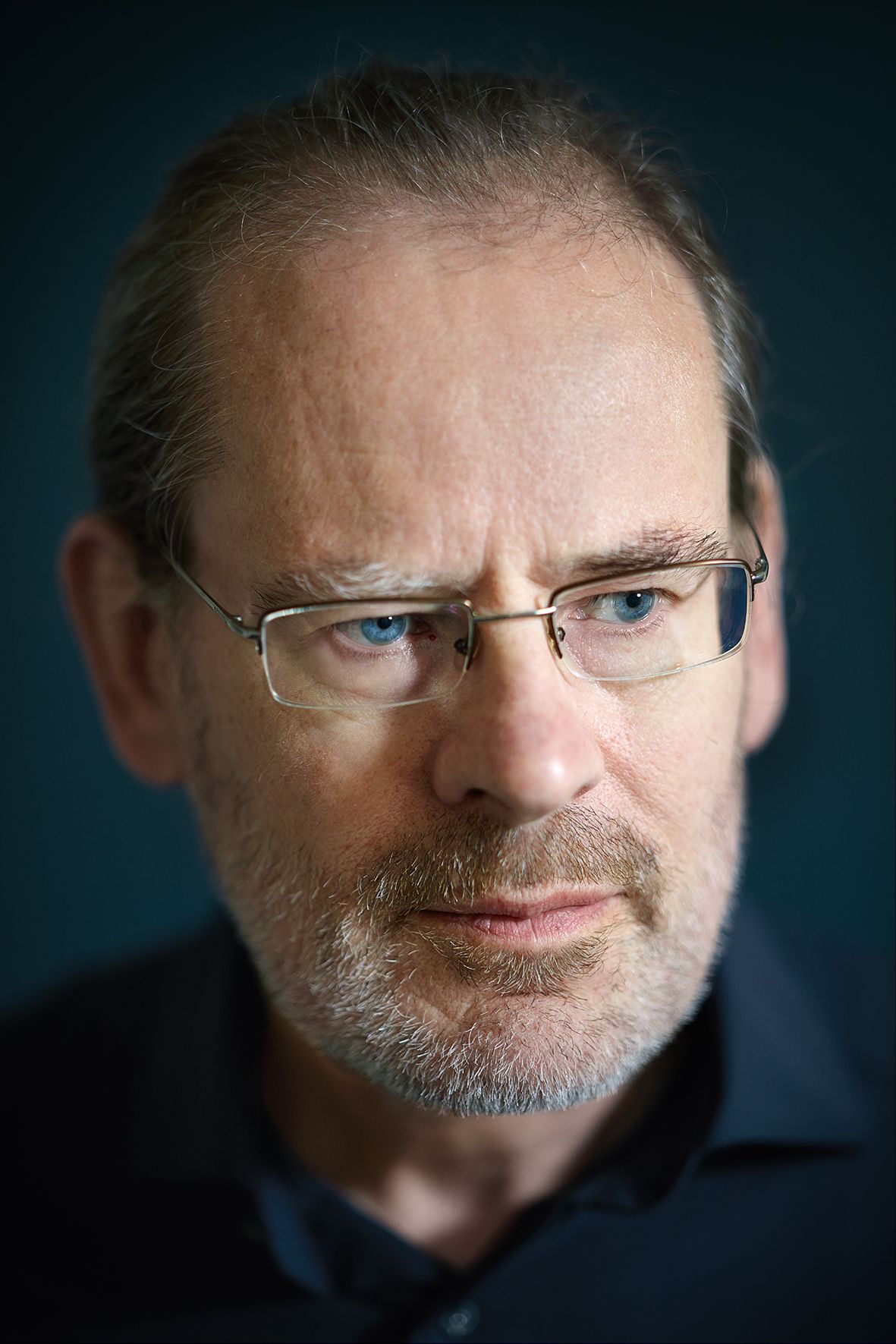

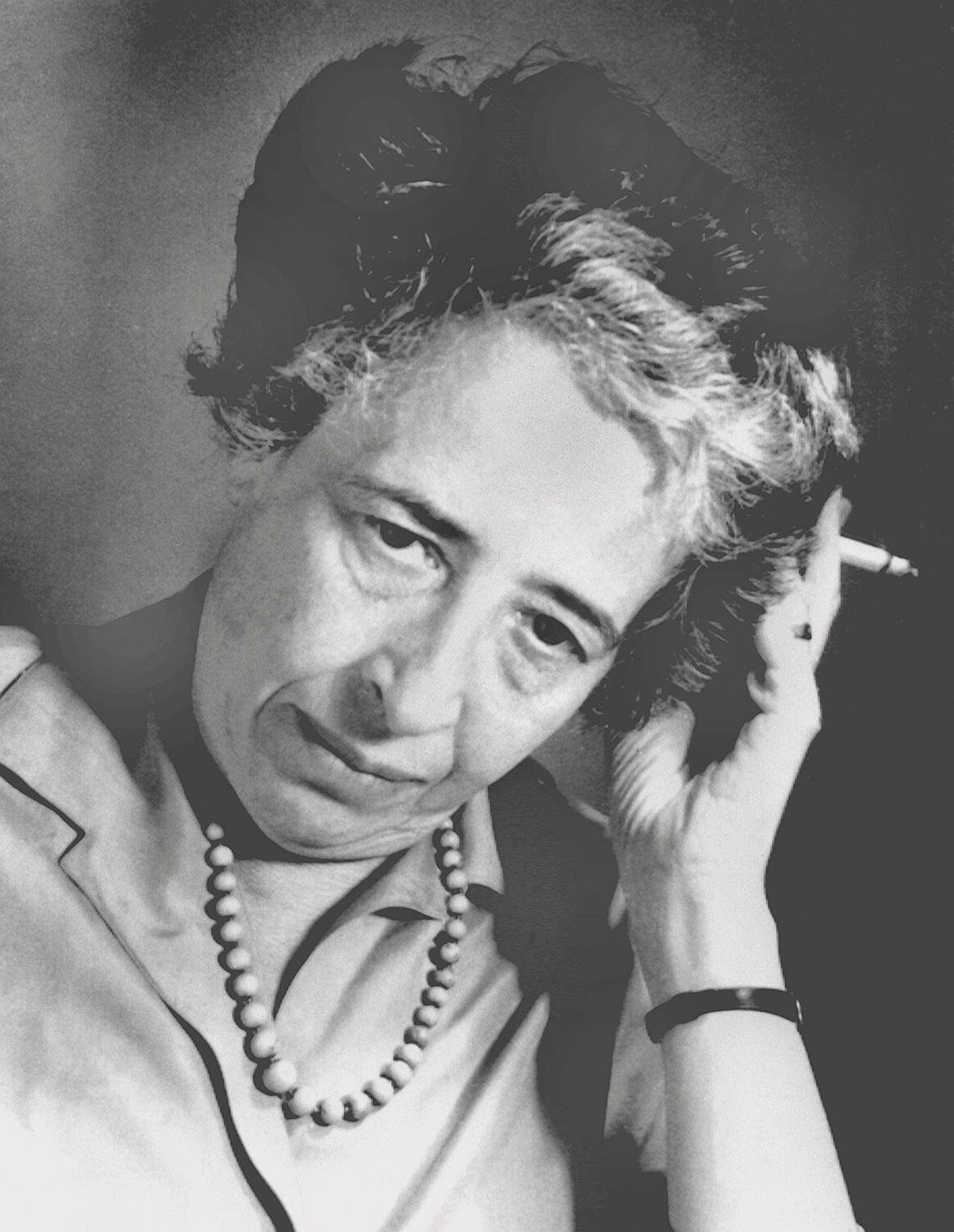

Hinrich Schütz an seinem Institut: „Ich bleibe davon überzeugt, dass wir uns am Menschen orientieren sollten.“ Foto: Oliver Jung

Mitte September 2023 kursierte ein Video in den Sozialen Netzwerken, das einen jungen Mann zeugt, der sich auf Twitter (X) „Jon Finger“ nennt.

Er berichtet auf Englisch von den Vorzügen einer neuen, durch Künstliche Intelligenz (KI, auch AI) gestützten automatischen Übersetzungssoftware, die angeblich jeden auf Video festgehaltenen Sprecher in nahezu jeder beliebigen Sprache mit seiner eigenen Stimme sprechen lassen kann: lippensynchron, unabhängig von der Position der Kamera und seines Gesichts, unabhängig von Lichtverhältnissen und Umgebungsgeräuschen. Ein Programm fürs Dolmetschen unter natürlichen Bedingungen, dem man nicht anmerken soll, dass eine Übersetzungssoftware für Bild (Mundbewegungen), Ton (Stimme) und (beliebige) Sprache verantwortlich zeichnet – und eben nicht ein polyglotter Sprecher.

Als Video besticht der Film in seiner legeren Unaufgeregtheit, ja Belanglosigkeit: kein optischer Hochglanz, kein geputzter CEO, kein arrangiertes Ambiente, kein Schnickschnack. Das Video bricht ab. Und beginnt sofort wieder. Diesmal spricht der junge Mann darin akzentfreies Französisch. Doch es ist, auf der Bildebene, dasselbe Video, in dem er gerade noch Englisch gesprochen hat. Wieder bricht das Video ab. Wieder beginnt es. Diesmal auf Deutsch. Man hört und sieht immer denselben Sprecher denselben Text sprechen, wieder in anderer Sprache. Selbst, wenn man genau hinschaut, sieht man keine „falschen“ Lippenbewegungen, man hört keine andere Stimme als die des Original-Sprechers. Jon Fingers Firma nennt sich „HeyGen“, sie wird mit dem Slogan beworben: „Keine Kamera? Keine Crew? Kein Problem!“

Doch. Das ist es.

Es braucht mehr. Automatische Übersetzung stellt immer noch eine technische Herausforderung dar, auch wenn sich die Anforderungen daran gründlich geändert haben. Die Verarbeitung natürlicher Sprache, das Natural Language Processing (NLP), bewirtschaftet ja einen Kreislauf: Menschlich gesprochene Sprache wird von einer Maschine akustisch erfasst, von ihr in Text verwandelt, die Textdaten werden semantisch verarbeitet, dann übersetzt und in eine andere gesprochene Sprache verwandelt. Die Umsetzung jedes einzelnen Teilschrittes in diesem Zirkel stand vor einem halben Jahrzehnt noch ganz am Anfang.

Wahrscheinlichkeiten von Laut-, Wort- und Satzfolgen erkennen

Die verblüffende Lösung für diese Probleme war dann: Man überspringt alle Teilschritte. Inzwischen verwenden Intelligenzen wie ChatGPT eine neuronale Netzwerkarchitektur und unüberwachtes Lernen, um Übersetzungen zu generieren. Sie können ohne expliziten Regelsatz lernen. Dafür mussten die Maschinen mit Unmengen an Audio- und Textdaten aus natürlichen Sprachen trainiert werden, um die Wahrscheinlichkeiten von Laut-, Wort- und Satzfolgen, gesprochen wie geschrieben, darin erkennen zu können. Plausibel sind KI-generierte Texte also darum, weil diese Intelligenzen über einen riesigen Fundus an gesprochenen und geschriebenen Texten (aus Medien, Büchern, Podcasts und Blogs) verfügen, die in ihrem ursprünglichen Kontext bereits als logisch, funktional und verständlich gehandhabt worden waren.

Was aber, wenn die verfügbaren Textvolumina für solche Trainings nur gering sind? Bei natürlichen Sprachen etwa mit nur lokaler Verbreitung, bei denen die Menge an verfügbaren gesprochenen und geschriebenen Texten dann auch nur marginal ist?

Hier kommt Professor Hinrich Schütze ins Spiel, ein Computerlinguist am Center for Information and Language Processing der LMU. In seinem Forschungsgebiet, der maschinengestützten Sprachverarbeitung, geht es darum, natürliche Sprache in Form von Textdaten algorithmisch zu verarbeiten und zu erzeugen. Die Computerlinguistik steht an der Schnittstelle zwischen Sprachwissenschaft und Informatik, es gibt sie seit den frühen 1960er-Jahren. Zu Anfang beschränkte sich die maschinelle Verarbeitung von Sprache auf das Erfassen begrenzter Textkorpora und die Erhebung statistischer Daten, etwa auf die Häufigkeit des Vorkommens und die Umfelder einzelner Worte oder Sentenzen im Werk Goethes. Doch mit Konkordanzen, Wort- und Formstatistik allein gelangte man nicht an automatische Übersetzungen.

Das Internet und der Siegeszug des Maschinellen Lernens revolutionierten aber die Möglichkeiten des „Natural Language Understanding“ (NLU) und der „Natural Language Generation“ (NLG), des Verstehens und der Synthese von Sprache, auch für die Computerlinguistik. „Ich erlebe gerade die interessanteste Zeit in meinem Fach. Plötzlich haben sich Intelligenzen entwickelt, die niemand richtig erklären kann“, resümiert Schütze die Technikrevolution. „An Künstlicher Intelligenz wird schon seit Jahrzehnten geforscht. Doch alle spezifischen Algorithmen, alle seriellen Methoden, die etwa dazu führten, dass IBM das KI-Programm Watson bauen konnte, sind im Nachhinein nicht so wichtig gewesen“, sagt Hinrich Schütze. „Skalierung war es: schiere Datenmengen und Computing Power und die daraus resultierende Größe der Modelle, so entstand Emergenz“, die den Intelligenzen also Eigenschaften neuer Qualität verlieh. „Sie ermöglichten Quantensprünge in der Sprachbehandlung. Wir sprechen schon einmal vom ‚God of Scale’. Wir verstehen ihn zwar nicht, aber er lässt uns arbeiten.“

Zuvor tastete man sich schrittweise von der Text- oder Spracheingabe in Richtung Bedeutung vor. Computer segmentierten Buchstabenketten in Wörter und Sätze, Personalformen und Fallmarkierungen wurden analysiert, um die grammatische Information zu extrahieren und die Wörter auf Grundformen zurückzuführen. Dann wurden die Wörter auf ihre strukturelle Funktion im Satz hin untersucht (Subjekt, Prädikat, Objekt, Artikel et cetera). Schließlich wurden Sätzen Bedeutungen zugeordnet und die Beziehungen zwischen aufeinander folgenden Sätzen bestimmt. Dieses konsekutive Verfahren blieb aufwendig, langwierig und fehlerbehaftet. Mit der Epiphanie des ‚God of Scale‘ wurde die Rückführung auf Syntax und Semantik für die Sprachverarbeitung von Maschinen nicht mehr für nötig befunden.. „Der Algorithmus geht nun nicht mehr Schritt für Schritt durch den Input, sondern es wird alles zusammen verarbeitet, parallel. So wie man ein Bild wahrnimmt. Das funktioniert auch wesentlich schneller.“

„Ich erlebe gerade die interessanteste Zeit in meinem Fach. Plötzlich haben sich Intelligenzen entwickelt, die niemand richtig erklären kann.“

Dass KI mittlerweile mit Englisch, Französisch, Deutsch, Spanisch, Chinesisch und Russisch umgehen kann, bedeutet nicht, dass sie alle Sprachen der Welt gleichermaßen beherrscht. Hier setzen denn auch Schützes aktuelle Forschungsprojekte an. „Es gibt mehr als 7.000 Sprachen auf der Welt, die man 400 Sprachfamilien zuordnen kann.

Nur für etwa 100 Sprachen stehen viele Ressourcen zur Verfügung. Für die meisten Sprachen gibt es nicht genug Trainingsdaten. Da kann man mit dem Sorbischen in Deutschland anfangen. Dann auch viele afrikanischen Sprachen. Die Sprachen der Ureinwohner in Amerika, Sprachen in Südostasien und Australien, Ozeanien.“

Bislang ignorieren die Vorreiter der KI-Technologie, zumeist amerikanische Unternehmen, die an einer kommerziellen Nutzung der automatischen Sprachen-Verarbeitung interessiert sind, die „kleinen“ oder „Low-Resource“-Sprachen, da sie sich davon keinen Gewinn versprechen. Der Mangel an technischer Unterstützung für Minderheitensprachen, ja, die Ausblendung ganzer Sprach-Gemeinschaften, stellt virtuelle Barrieren auf und vergrößert den „Digital Divide“, die digitale Kluft. Schütze beginnt darum hier: mit dem Sammeln von Sprach-Daten und der Kategorisierung von Verwandtschaften für diese kleinen Sprachen.

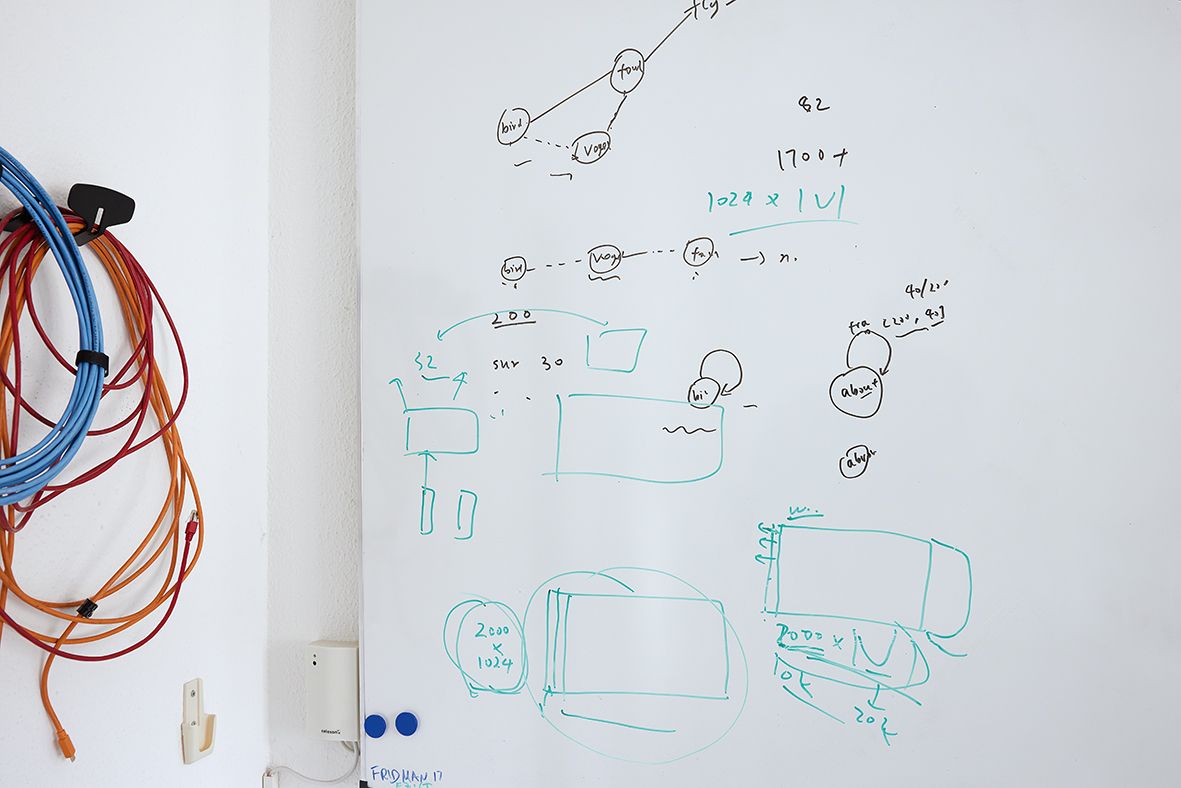

Bestehende Typologien ordnen Sprachen nach ihren geografischen Merkmalen (zum Beispiel dem Kontinent, auf dem die Sprache gesprochen wird), ihren phylogenetischen Merkmalen (genealogischen Beziehungen zwischen Sprachen) oder ihren strukturellen Merkmalen (Morphologie und Syntax ). Schützes Ansatz kann mit KI jedoch über 1.000 Sprachen untersuchen, weil er sie mithilfe eines „superparallelen Datensatzes“, des Parallel Bible Corpus (PBC), miteinander vergleicht. Denn kein anderes Buch wurde in so viele Sprachen übersetzt wie die Bibel. Angefangen bei der Septuaginta im Jahr 250 vor Christus ist die Heilige Schrift bis heute das Objekt der intensivsten Übersetzungsaktivität weltweit.

Mittlerweile steht eine große Anzahl von Bibelübersetzungen in elektronischer Form zur Verfügung, was Schütze ermöglicht, viele verschiedene Sprachen parallel zu analysieren. „Wir arbeiten gleichzeitig an mehreren Sprachen“, sagt Schütze, „mal am Wallonischen, mal an einer afrikanischen, mal an einer ozeanischen Sprache. Es ist nicht so, dass wir uns auf eine Sprache konzentrieren, die abhaken, dann kommt die nächste. Wir arbeiten parallel an allen.“

Seine Methode der „Conceptualization“ versucht zuerst, in dem gigantischen Korpus Ähnlichkeiten und Unterschiede zu finden, etwa, wie Sprachen die Welt in Konzepte aufteilen und was sie damit verknüpfen. Zum Beispiel verbinden Chinesisch, Japanisch und Koreanisch alle das Konzept „Mund“ mit „Eingang“ aufgrund des Einflusses des chinesischen Schriftzeichens. Diese Verknüpfung fehlt in europäischen Sprachen, was darauf hinweist, dass die drei ostasiatischen Sprachen eine ähnliche Konzeptualisierung ihrer Sprachwelt teilen, die sich von europäischen Sprachen deutlich unterscheidet. Die konzeptionelle Ähnlichkeit ergänzt herkömmliche Verfahren, die auf lexikalischen und typologischen Ähnlichkeiten basieren.

Wie aber kommt der Forscher an neue Sprachdaten, wenn sie kaum verfügbar sind?

„Eine Möglichkeit ist“, so Schütze, „dass man alles crawlt, was es in dieser Sprache im Web gibt. Das ist zuerst nicht einfach, die Klassifikation bleibt schwierig. Doch nach und nach erarbeitet man sich ein Korpus und kann eine KI damit trainieren. Wir lassen das trainierte System dann etwa erklären, worum es in einem Satz geht, dessen Inhalt wir zwar kennen, der sich aber nicht in den Trainingsdaten der KI befunden hat. Wenn das Modell korrekt antwortet, dann zeigt das, dass es etwas über die Sprache gelernt hat. Die Evaluation der KI-Fähigkeiten erfolgt über die großen Textkorpora, in denen wir ja Sätze haben, die bereits übersetzt sind. Doch neben der Datenknappheit für kleinere Sprachen, bleibt das Hauptproblem einer Arbeit mit KI das Auftreten von Halluzinationen.“

„Explizites Memory ist ein entscheidendes Merkmal von Intelligenz. Es gibt nur eine Instanz von echter Intelligenz, das ist der Mensch.“

Das mit Datenmassen bestückte KI-Modell, so Schütze, verfüge nicht über ein „explizites Gedächtnis“. Es probiert sinnvolle Wahrscheinlichkeiten in einer Sprache aus. Intelligentes Sprechen aber setzt ein Gedächtnis voraus, um Wahrscheinlichkeiten von Fakten zu unterscheiden. Die KI dagegen improvisiert jedoch Wissen, auch dann, wenn sie nicht über Fakten verfügt. So kommt es zu Halluzinationen, syntaktisch korrekten, aber rein erfundenen Antworten, etwa einer Quelle zu einem – vermeintlichen – Zitat, die es gar nicht gibt. Schützes Team arbeitet darum daran, den Künstlichen Intelligenzen Gedächtnis mitzugeben und sie auf Faktenwissen zu trainieren. Damit sie neben dem impliziten Wissen, wie eine Sprache funktioniert, auch ein explizites Wissen darüber aufbauen zu können, was stimmt, um bloß gut klingende Antworten von faktenbasierten zu unterscheiden und letztere zu bevorzugen.

Die Aufrüstung der Sprachmodelle mit einem „Controller“

Vor diesen Problemen stehen gegenwärtig noch alle Sprachverarbeitungsmodelle, auch ChatGPT: Ohne nachführende Kooperation mit dem Menschen, die „Human-Centric NLP“, und eine starke Verknüpfung mit Wissensdatenbanken mangelt es den Intelligenzen an sachlicher Korrektheit. Es resultieren Bias und Halluzinationen, in denen die KI-Modelle Antworten generieren, die nicht sinnvoll, unlogisch oder nicht relevant sind. In einem ersten Schritt etwa könnte etwa ChatGPT dazu gebracht werden, Quellenangaben für seine Antworten mitzuliefern, die heute noch fehlen. Schütze arbeitet darum an einer Aufrüstung der Sprachmodelle um einen „Controller“, ein „Working Memory“, welches das Speichern von Information wie den Abruf von Wissen veranlasst. Doch wann soll die Maschine etwas im expliziten Memory speichern und wann soll sie es abrufen? „Das ist immer noch ein Riesenproblem“, so Schütze. „Explizites Memory ist jedoch ein entscheidendes Merkmal von Intelligenz. Es gibt nur eine Instanz von echter Intelligenz, das ist der Mensch. Daran sollten wir uns für Künstliche Intelligenz orientieren“, führt Schütze aus. „Es gibt jedoch auch die Auffassung, dass das gar nicht nötig sei. Flugzeuge schlagen nicht wie Vögel mit den Flügeln und fliegen trotzdem. Genauso könnte es ja bei der KI sein, dass die Maschine intelligent ist, aber eben ganz anders funktioniert. Doch bleibe ich davon überzeugt, dass wir uns am Menschen orientieren sollten. Weil unsere Intelligenz nur mit Gedächtnis funktioniert.“

Bernd Graff

Prof. Dr. Hinrich Schütze ist Inhaber des Lehrstuhls für Computerlinguistik und Co-Direktor des Centrums für Informations- und Sprachverarbeitung (CIS) an der LMU. Schütze, Jahrgang 1964, studierte Informatik in Braunschweig und Stuttgart. Seinen Ph.D. machte er in Computerlinguistik an der Stanford University, Kalifornien, USA. Anschließend arbeitete Schütze fünf Jahre am Xerox Palo Alto Research Center und weitere fünf Jahre als Gründer und Führungskraft bei Suchmaschinen- sowie Textminingunternehmen im Silicon Valley. Schütze war Inhaber des Lehrstuhls für Theoretische Computerlinguistik an der Universität Stuttgart, bevor im Jahre 2013 an die LMU berufen wurde. Er ist Fellow der Association for Computational Linguistics, des European Laboratory for Learning and Intelligent Systems und von HessianAI. Im Jahr 2018 sprach ihm der Europäische Forschungsrat (ERC) einen seiner Advanced Grants zu.

0 Kommentare