Wenn man mit Stefan Feuerriegel, Leiter des LMU-Instituts für Künstliche Intelligenz (KI) im Management, über sein Metier gesprochen hat, dann bleibt vor allem eine Aussage des Forschers hängen: Er verbringe viel Zeit damit, so Feuerriegel, seinen Studenten, „aber auch den Managerinnen und Managern aus den unterschiedlichsten Unternehmen zu erklären, was KI alles nicht kann.“ Sein Job sei dabei vor allem, „die übergroßen Erwartungen runterzuschrauben. Wenn mir das gelungen ist, können wir damit anfangen, erfolgreich mit KI zu arbeiten.“

Die Bemerkung des Professors hallt deswegen nach, weil KI derzeit entweder für das universale Allheilmittel oder aber für die menschheitsbedrohende Überintelligenz gehalten wird, deren Wirkweisen so oder so noch gar nicht abzuschätzen sind. Man ist gleichzeitig beeindruckt von den kreativen Hervorbringungen der KI und fürchtet doch eine aufkommende Autonomie der Rechner-Intelligenzen, die eigenmächtig Initiativen zur Gestaltung von Gesellschaft, Kultur und Geschichte ergreifen könnten. KI sei kein Werkzeug, sondern ein Akteur, so lautet die Befürchtung, die mitunter weit über ein Unbehagen hinausgeht. KI erscheint da als eine sich selbst organisierende „Black Box“, deren Entscheidungsfindungen die Kapazitäten menschlichen Denkens übersteigen und mysteriös bleiben. KI denke schneller, verarbeite mehr Informationen und berücksichtige mehr Parameter, als Menschen es je könnten. Mit KI scheine ein übermächtiger Gegenspieler erwachsen zu sein. Was ist dran an solchen Ängsten?

Nicht viel, wenn man Stefan Feuerriegel und seinem Ansatz folgt, wie sich diese Technologien erfolgreich implementieren lassen.

Muster, Bilder, Texte, Musik: KI ist erfolgreich in ihrem digitalen Habitat

„Für uns ist zentral, dass wir die Entscheiderinnen und Entscheider, kommen sie nun aus dem Management, der Wissenschaft oder der Politik, in allen Phasen der AI-Implementierung im ‚Driver‘s Seat‘ lassen“, sagt Feuerriegel. „Sie müssen ihre konkreten Probleme gelöst sehen und verstehen, wie die KI jeweils zu ihren Lösungsvorschlägen kommt.“ Die konkreten Anwendungen von KI blieben vor allem im Management auf eine relativ kleine Teilmenge von Problemen beschränkt. Weitreichende Entscheidungen wie bei Fusion, Übernahme oder Schließung von Unternehmen berührten fundamentale rechtliche und ethische Fragen. „Sie müssen in den Händen von Managerinnen und Managern bleiben.“ KI könne daher nur als Input für menschliche Entscheidungsprozesse dienen, nicht als deren Ersatz. „KI formuliert also keine grundsätzlichen Managementpositionen“, stellt Feuerriegel klar. „Sie hilft dabei, fundierte Entscheidungen zu treffen.“

KI ist eine rein mathematische Intelligenz. Sie ist Software, es sind Algorithmen, die auf Computern implementiert sind. Die Grenzen dieser rein mathematischen Umsetzung von Intelligenz liegen – abseits der Größe der Datensätze, mit denen sie trainiert werden – damit in den Grenzen der Mathematik selber. Nur die Probleme und Aufgabenstellungen aus der realen Welt, die sich in mathematischen Funktionen abbilden lassen, können von einer KI erfolgreich bearbeitet werden. KI kann in ihrem digitalen Habitat sehr gut Muster erkennen, Bilder, Texte, Stimmen und Musik synthetisieren und Fehler in der Konstruktion von Produkten identifizieren. Doch sie kann nicht Recht sprechen, Politik machen oder den richtigen Lebenspartner finden. Sie scheitert mitunter in der Konfrontation mit den komplexen Fragestellungen der Wirklichkeit.

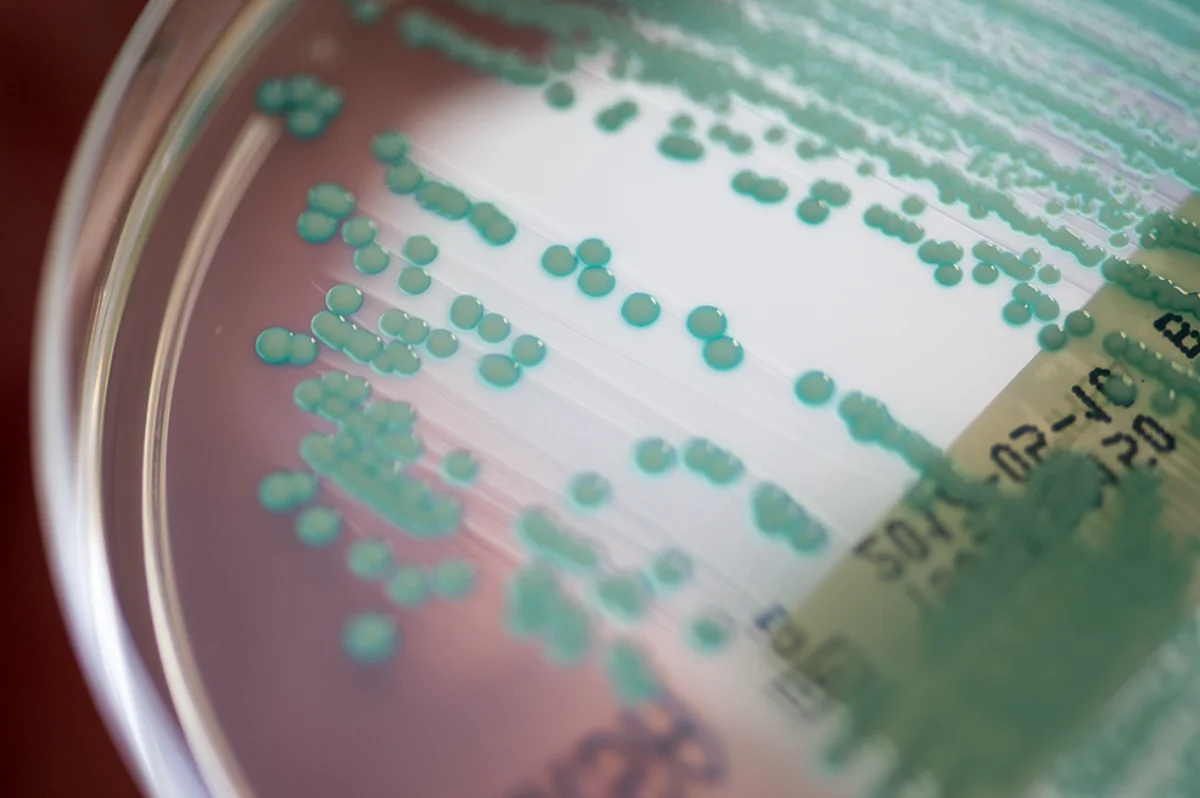

Eine wichtige Säule der heutigen KI sind künstliche neuronale Netze, die als Deep-Learning-Netze aufgebaut sind. Das sind auf Computern laufende mathematische Simulationen, von denen man annimmt, dass damit die Informationsverarbeitung des Gehirns modelliert werden kann. Jedes maschinelle Lernen ist Lernen aus Daten. Das aber heißt: Damit Problemstellungen von der lernenden mathematischen Funktion einer KI abgebildet werden können, müssen ausreichend grundlegende Daten vorhanden sein.

Immer wieder macht Feuerriegels Team Proben aufs Exempel: So wurden seine Large Language Models (LLMs) etwa darauf trainiert, die langfristige Wirkung von Hate Speech in den Sozialen Medien zu verfolgen. „Wir konnten auch quantitativ nachweisen, wie infektiös Hate Speech ist. Die Kaskaden, in denen sie sich im Netz verteilt, werden größer, halten sich länger und weisen eine größere strukturelle Viralität auf als die von ,normalen‘ Posts“, sagt Feuerriegel. Ebenso half die Methode seinem Team Zusammenhänge von Emotionen und Viralität von Fake News erkennen. Auch pro-russische Propaganda seit Beginn des völkerrechtswidrigen Angriffs auf die Ukraine konnten die Wissenschaftlerinnen und Wissenschaftler so identifizieren und etwa die Aktivitätspeaks pro-russischer Bot-Armeen im Gefolge der militärischen Invasion nachzeichnen.

Stefan Feuerriegel rät seinen Studierenden wie Auftraggebern darum nicht nur, vor jeder KI-Implementierung erst einmal die eigene Datenlandschaft auf Größe und Konsistenz zu überprüfen. Und er fordert sie auf, exakt zu bestimmen, welches Problem sie konkret von einer KI gelöst sehen wollen. „Wir entwickeln, implementieren und beurteilen auf dieser Grundlage neue KI-Algorithmen, um die Entscheidungsprozesse von Menschen zu optimieren. Und es kann nicht oft genug betont werden: Menschen entscheiden“, sagt Stefan Feuerriegel. „Darum müssen die Vorschläge, die Künstliche Intelligenzen machen, plausibel und nachvollziehbar bleiben.“

Für uns ist zentral, dass wir die Entscheiderinnen und Entscheider in allen Phasen der KI-Implementierung im ‚Driver‘s Seat‘ lassen.

Seine Anwendungsfälle für Unternehmen sind darum so gestaltet, dass der jeweils aufgespannte KI-Rahmen Manager dazu in die Lage versetzt, evidenzbasierte Entscheidungen gemäß den selbstgesetzten Maßgaben zu treffen. Dieser immer auf die Entscheider zentrierte Ansatz seiner „vertrauenswürdigen KI“, sagt Feuerriegel, ist erstaunlich vielseitig. Der LMU-Wissenschaftler hilft etwa Investoren dabei, erfolgversprechende Startups auf Plattformen für Venture Capital ausfindig zu machen. Maschinelles Lernen ermöglicht etwa auch, die Mittel für Entwicklungshilfe effizient zu vergeben oder den Effekt von Innovationen beim Einsatz neuer Klima-Technologien zu verfolgen.

Ergebnisse aus dem opaken Maschinenraum der Intelligenzen

Doch trotz der Vorteile dieses „Human-in-the-Loop“-Ansatzes fällt es Unternehmen immer noch schwer, Managerrollen und KI-Anwendungen in kollaborativen Lösungsansätzen sinnvoll zu kombinieren. Einer der einsichtigsten Gründe ist, dass Verantwortlichkeiten nicht an Maschinen delegiert werden dürfen. Organisationen verzögern darum Veränderungen. Und Bedenken gegen KI bleiben bestehen: Wann und wie sollten Manager in diese rechnergestützten Prozesse eingreifen? Sollten sie alle Teilschritte bei einer Entscheidungsfindung absegnen oder nur solche mit hohem Risiko, bei denen die KI zwar Ergebnisse liefert, von denen indes unklar bleibt, wie genau sie im opaken Maschinenraum der Intelligenzen zustande gekommen sind?

Zudem gibt es in fast allen Unternehmen einen über Jahrzehnte angesammelten, höchst spezifischen Datenschatz und eigene Experten mit hohem implizitem Wissen. Auf solch originärem Wissen basieren oft der Erfolg der Firmen. Wie also können diese exklusiven Daten fruchtbar für KI-Prognosen eingesetzt werden, aber so, dass die exklusive Expertise nicht in die Hände Dritter gerät. „Interpretierbarkeit bleibt darum der Schlüssel“, sagt Stefan Feuerriegel. „Wenn wir Managern raten, ihre Erwartungen an KI herunterzuschrauben, tun wir das nicht, um sie zu desillusionieren, sondern um sie ins Boot zu holen.“

Feuerriegels Einsatz von KI kann grob in zwei Kategorien unterteilt werden: in von Natur aus interpretierbare Modelle und in Post-hoc-Erklärmodelle. Bei von Natur aus interpretierbaren Algorithmen kann die Entscheidungsfindung des Algorithmus von Menschen unmittelbar nachvollzogen werden, zum Beispiel durch die Einsicht der Aufteilungsregeln in Entscheidungsbäumen oder durch Bestimmung der Koeffizienten in der von den Algorithmen angewandten linearen Regression. Lineare Regression bedeutet, die Beziehung zwischen Variablen „plausibel zurückzuführen“. Die KI nutzt dabei vorhandene Daten, um Aus- und Vorhersagen über die Beziehung zwischen ihnen zu machen und „regrediert“ sie, um aufzuzeigen, wie die Veränderung einer Variable eine andere Variable beeinflusst.

„Und wenn Managerinnern und Manager hören, dass wir mit unserer KI nichts anderes als das Verfahren der Linearen Regression anwenden“, so Feuerriegel, „also etwas, was sie im zweiten Semester ihres Studiums gelernt haben, dann merken sie, dass KI kein Hexenwerk ist, sondern einfach ein bisschen Mathematik, kombiniert mit Rechenzeit und guten Daten.“ Mit dem Modell einer solch generalisierten linearen Regression haben Feuerriegel und sein Team etwa untersucht, wie sich Strompreise in Abhängigkeit von Wetterdaten prognostizieren lassen. Oder aber sie konnten Aussagen darüber zu machen, wie lange eine Maschine in einem Unternehmen noch eingesetzt werden kann, bevor sie ersetzt werden muss.

Post-hoc-Erklärtechniken, die andere Variante der von Feuerriegel favorisierten KI-Modelle, kommen dann zum Einsatz, wenn die inneren Abläufe eines KI-Algorithmus zu komplex werden, um von Menschen verstanden zu werden, wie etwa bei den Vorgängen in tiefen neuronalen Netzen. Es sind Methoden, die nachträglich dazu verwendet werden, die Ergebnisse von Black-Box-Algorithmen zu erklären, indem man sie durch ein einfacheres Modell veranschaulicht, etwa durch Heatmaps. Sie heben visuell die Bereiche hervor, die für die von der KI getroffenen Vorhersagen am relevantesten sind. Experten können die KI-Erklärungen dann mit ihrem Fachwissen vergleichen, sie validieren oder die KI überstimmen, wenn sie nicht korrekt ist.

Wir stellen den Unternehmen aber zwei Glaskugeln zur Verfügung. Wir zeigen einmal, was eine Entscheidung bewirkt. Und einmal, was passiert, wenn man sich davor drückt.

So hat Feuerriegel im Qualitätsmanagement bei der Herstellung von Halbleitern „digitale Zwillinge“ einer realen Produktion erstellt – es sind Echtzeit-Virtualisierungen der entsprechenden realen, physischen Entscheidungsumgebungen –, in denen die KI fehlerhafte Produkte parallel zu menschlichen Prüfern mit Heatmaps markiert und deren Identifizierung begründet. Feuerriegel nennt solche Hilfestellungen gerne „minimalinvasive KI“.

Was, wenn der Patient das Medikament nicht bekommen hätte?

Ein weiteres Modell der LMU-Forscher als „Counterfactual Inference“, als Schlussfolgerung aus einer „Was-wäre-wenn“-Frage. Es geht darum, eine KI simulieren zu lassen, was passiert wäre, wenn sie andere Variablen unter anderen Bedingungen verwendet hätte und demnach zu anderen Ergebnissen gekommen wäre. Counterfactual Inference untersucht also hypothetische Situationen mit derselben mathematischen Akribie wie die faktischen. Das ist nützlich, um kausale Zusammenhänge zu verstehen und zu klären, ob eine bestimmte Entscheidung wirklich einen positiven Effekt hatte. Feuerriegel bringt ein Beispiel aus der Medizin: Angenommen, ein Patient bekommt ein Medikament und wird gesund. Die kontrafaktische Simulation errechnet, was passiert wäre, wenn der Patient das Medikament nicht oder in anderer Dosierung genommen hätte. Wäre er trotzdem gesund geworden? Counterfactual Inference hilft also herauszufinden, wie groß der Einfluss einer Entscheidung oder eines Ereignisses tatsächlich auf das Ergebnis ist.

Feuerriegel hat auch mit den Betreibern der Webseite einer namhaften überregionalen Tageszeitung zusammengearbeitet, um herauszufinden, welche Inhalte zu welcher Tageszeit an welcher Stelle ihrer Homepage platziert werden sollen.

„Werde ich gefragt werde, wie ich mich verstehe, bezeichne ich mich als ‚Problemlöser‘“, sagt Stefan Feuerriegel. „Um Probleme lösen zu können, müssen die Organisationen aber ihren Beitrag leisten und vorabdefinieren, was genau ihr Problem ist. Wir entwickeln dann Algorithmen, die genau dazu passen.“ Es gebe eben nicht „die eine KI für alle Fälle“, jedes Problem müsse man anders angehen. „Wir stellen den Unternehmen aber zwei Glaskugeln zur Verfügung. Wir zeigen einmal, was eine Entscheidung bewirkt. Und einmal, was passiert, wenn man sich davor drückt.“

Bernd Graff

Prof. Dr. Stefan Feuerriegel leitet das Institut für Künstliche Intelligenz (KI) im Management an der LMU. Er hat eine Doppelprofessur an der LMU Munich School of Management und der Fakultät für Mathematik, Informatik und Statistik der LMU. Feuerriegel, Jahrgang 1989, studierte an der RWTH Aachen und wurde mit einer Arbeit am Lehrstuhl für Wirtschaftsinformatik der Universität Freiburg promoviert. Feuerriegel war Assistenzprofessor an der ETH Zürich, bevor er 2021 an die LMU kam.

0 Kommentare